Disquete é um disco de mídia magnética removível, para armazenamento de dados. O termo equivalente em inglês é floppy-disk, significando disco flexível.

Pode ter o tamanho de 3,5 polegadas com capacidade de armazenamento de 720 KB (DD=Double Density) até 5,76 MB (EDS=Extra Density Super), embora o mais comum atualmente seja 1,44 MB (HD=High Density), ou 5,25 polegadas com armazenamento de 160 KB (Single Side = Face Simples) até 1,2 MB (HD).

Histórico dos formatos de disquete

Um disquete de 8 polegadas.Os (as) disquetes tiveram diferentes tamanhos e formatos desde que foram inventados, em 1971, com o último formato (3½-polegadas (inch) HDS) a ser definitivamente adotado.

Tipo de disco Ano Capacidade

8-inch 1971 80 kB

8-inch 1973 256 kB

8-inch 1974 800 kB

8-inch dual-sided 1975 1MB

5¼-inch 1976 160 kB

5¼-inch DD 1978 360 kB

5¼-inch QD 1980 720 KB

5¼-inch HD 1984 1.2 MB

3-inch 1984? 320 kB

3½-inch 1984 720 kB

3½-inch HD 1987 1.44 MB

3½-inch ED 1991 2.88 MB

3½-inch EDS 1993 5.76 MB

Outras características dos disquetes

Disquete de 5"1/4

Disquete de formato 5,25 polegadas.Tipo Usado em Setores por trilha trilhas por Face Capacidade Taxa de transferência de bits

Dupla Densidade P.C./XT 8 40 160/320 KB 250 KBit/s

Dupla Densidade P.C./XT 9 40 180/360 KB 250 KBit/s

Quadrupla Densidade AT 8 80 720 KB 300 KBit/s

Alta Densidade AT 15 80 1,2 MB 500 KBit/s

A capacidade dos disquetes 5"1/4, nos modelos mais antigos de leitora, é limitado a uma face. Neste caso, embora a mídia permita, apenas uma das faces é acessada de cada vez. Nos modelos mais novos, com duas cabeças de leitura/escrita, ambas as faces são acessadas.

Disquete de 3"1/2

Tipo Usado em Setores por trilha Trilhas por Face Capacidade Taxa de transferência de bits

Dupla Densidade P.C./XT 9 80 720 KB 250 Kbit/s

Alta Densidade AT 18 80 1,44 MB 500 Kbit/s

Alta Densidade Extra AT 36 80 2,88 MB 1 Mbit/s

Alta Densidade Extra Super AT 72 80 5,76 MB 2 Mbit/s

Por dentro do disquete

Legenda:

1 - Trava de proteção contra escrita. 2 - Base central. 3 - Cobertura móvel. 4 - Chassi (corpo) plástico. 5 - Disco de papel. 6 - Disco magnético. 7 - Setor do disco.Os disquetes possuem a mesma estrutura de um disco rígido sendo todos periféricos de entrada e saida, tendo como diferenças o fato dos disquetes poderem ser removíveis e o fato dos disquetes serem compostos de um único disco magnético.

Os disquetes são divididos em pistas. Um conjunto de pistas concêntricas repartidas em intervalos regulares definem a superfície magnética do disco. As pistas são numeradas de 0 a n, sendo n o número total. A pista 0 é a mais externa.

Cada cilindro é dividido em um número constante de partes de mesmo tamanho, denominado setor. O nome destes depende do formato do disquete e são numerados de 1 até n, sendo n o número de setores por pista.

Cada setor possui o tamanho de 512 bytes. O setor (ou bloco) é a menor porção do disco que o computador consegue ler.

O disco magnético geralmente é dividido em duas faces, denominadas 0 e 1. Alguns leitores mais atuais, visto que os discos possuem essas duas faces, são equipados com duas cabeças de leitura/escrita, uma para cada face do disco.

Para se calcular a capacidade do disquete, pode-se usar a fórmula: Número de faces × número de pistas × números de setores/pista × 512 bytes/setor.

Problemas

As unidades de leitura geralmente possuem um botão que, se pressionado ejeta o disquete. A possibilidade de ejetar o disquete mecanicamente pode acarretar erros de leitura, ou até mesmo a perda de todos os dados contidos no disquete caso a ejeção seja feita durante um processo de leitura. Uma exceção a isso é constituído pelas unidades de leitura dos computadores Macintosh, nos quais a ejeção do disco é comandada pelo sistema operacional e realizada através de um motor interno.

Um outro problema é referente à sua vida útil. Os disquetes possuem vida útil que varia de 5 a 6 anos (pouco, se for comparado ao CD, que dura 20 anos). Disquetes mais velhos e com muito uso, começam a desprender fragmentos do disco magnético interno, sendo que alguns desses fragmentos podem grudar nas cabeças de leitura, dificultando muito a leitura/escrita de outros disquetes. Para essa situação, é recomendável utilizar um "disquete" especial para limpeza, em que no lugar do disco magnético fica localizado um tecido para limpeza.

Desuso

Disquete estilizado.O disquete já foi considerado um dispositivo com grande capacidade de armazenamento, especialmente devido ao pequeno tamanho dos arquivos. Atualmente, devido ao tamanho cada vez maior dos arquivos e, devido à existência de mídias de armazenamento não-voláteis de maior capacidade, como Zip Disks, cartões de memória (memory sticks, cartões MMC, cartões SD, ...), Flash Drives USB (muitas vezes em formato de chaveiro), CD-R, CD-RW, DVD gravável e regravável; além de existir outras maneiras de guardar arquivos, como armazenamento distribuído e/ou Compartilhamento de arquivos em redes locais, e-mail e disco virtual, o disquete se tornou um utilitário obsoleto. Muitos fabricantes de computadores dão como certa a "morte" dos disquetes e que os computadores do futuro não terão mais drives de disquetes. O maior problema em relação aos disquetes é justamente o problema do disquete velho : o disquete possui uma "vida útil" de 5 anos. Após esse prazo, a sua camada magnética começa a se danificar e aí pode haver perda de dados. O pior dessa situação é que a camada magnética começa a realmente se descolar da camada plástica do disquete, sujando as cabeças de leitura/gravação. Para resolver esse problema, basta limparmos as cabeças de leitura e gravação da unidade de disquete com um disco de feltro especial. Em geral esse disco vem junto com um vidrinho contendo álcool isopropílico que é usado na limpeza.

Meio de Contaminação de Vírus

Os disquetes foram os primeiro transmissores de vírus de computador, no fim dos anos 80, o Vírus Ping-Pong, Vírus Stoned, Vírus Jerusalem e Vírus Sexta-Feira 13 eram disseminados através do disquete. Que contaminava o PC quando inserido na máquina, e após contaminar ele contaminava qualquer outro disquete sem vírus que fosse inserido no drive do PC. Até o surgimento na Internet, o disquete era o único meio de propagação de vírus que existia.

Na época o único meio de proteger um disquete contra vírus era colocar um selo no lacre quadrangular superior ou, no caso dos disquetes de 3"½, ativar a trava de proteção contra escrita, de forma a impedir que o PC gravasse qualquer coisa no disquete, fazendo dele um meio de leitura de dados somente, protegendo assim, de vírus.

sexta-feira, 30 de abril de 2010

quinta-feira, 29 de abril de 2010

Disco rígido

Disco rígido ou disco duro, no Brasil popularmente chamado também de HD (derivação de HDD do inglês hard disk drive) ou winchester (termo em desuso), "memória de massa" ou ainda de "memória secundária" é a parte do computador onde são armazenados os dados. O disco rígido é uma memória não-volátil, ou seja, as informações não são perdidas quando o computador é desligado, sendo considerado o principal meio de armazenamento de dados em massa. Por ser uma memória não-volátil, é um sistema necessário para se ter um meio de executar novamente programas e carregar arquivos contendo os dados inseridos anteriormente quando ligamos o computador. Nos sistemas operativos mais recentes, ele é também utilizado para expandir a memória RAM, através da gestão de memória virtual. Existem vários tipos de discos rígidos diferentes: IDE/ATA, Serial ATA, SCSI, Fibre channel, SAS, SSD.

História do disco rígido

Um antigo disco rígido IBM.O primeiro disco rígido foi construído pela IBM em 1956, e foi lançado em 16 de Setembro de 1957. Era formado por 50 discos magnéticos contendo 50 000 setores, sendo que cada um suportava 100 caracteres alfanuméricos, totalizando uma capacidade de 5 megabytes, incrível para a época. Este primeiro disco rígido foi chamado de 305 RAMAC (Random Access Method of Accounting and Control) e tinha dimensões de 152,4 centímetros de comprimento, 172,72 centimetros de largura e 73,66 centímetros de altura. Em 1973 a IBM lançou o modelo 3340 Winchester, com dois pratos de 30 megabytes e tempo de acesso de 30 milissegundos. Assim criou-se o termo 30/30 Winchester (uma referência à espingarda Winchester 30/30), termo muito usado antigamente para designar HDs de qualquer espécie. Ainda no início da década de 1980, os discos rígidos eram muito caros e modelos de 10 megabytes custavam quase 2 mildólares americanos, enquanto em 2009 compramos modelos de 1.5 terabyte por pouco mais de 100 dólares. Ainda no começo dos anos 80, a mesma IBM fez uso de uma versão pack de discos de 80 megabytes, usado nos sistemas IBM Virtual Machine. Os discos rigidos foram criados originalmente para serem usados em computadores em geral. Mas no século 21 as aplicações para esse tipo de disco foram expandidas e agora são usados em câmeras filmadoras, ou camcorders nos Estados Unidos; tocadores de música como Ipod, mp3 player; PDAs; videogames, e até em celulares. Para exemplos em videogames temos o Xbox360 e o Playstation 3, lançados em 2005 e 2006 respectivamente, com esse diferencial, embora a Microsoft já tivesse lançado seu primeiro Xbox (em 2001) com disco rígido convencional embutido. Já para celular os primeiros a terem esse tecnologia foram os da Nokia e da Samsung. E também devemos lembrar que atualmente o disco rigido não é só interno, existem também os externos, que possibilitam o transporte de grandes quantidades de dados entre computadores sem a necessidade de rede.

Como os dados são gravados e lidos

Os discos magnéticos de um disco rígido são recobertos por uma camada magnética extremamente fina. Na verdade, quanto mais fina for a camada de gravação, maior será sua sensibilidade, e conseqüentemente maior será a densidade de gravação permitida por ela. Poderemos, então, armazenar mais dados num disco do mesmo tamanho, criando HDs de maior capacidade. Os primeiros discos rígidos, assim como os discos usados no início da década de 80, utilizavam a mesma tecnologia de mídia magnética utilizada em disquetes, chamada coated media, que além de permitir uma baixa densidade de gravação, não é muito durável. Os discos atuais já utilizam mídia laminada (plated media), uma mídia mais densa, de qualidade muito superior, que permite a enorme capacidade de armazenamento dos discos modernos. A cabeça de leitura e gravação de um disco rígido funciona como um eletroímã semelhante aos que estudamos nas aulas de ciências e física do colegial, sendo composta de uma bobina de fios que envolve um núcleo de ferro. A diferença é que, num disco rígido, este eletroímã é extremamente pequeno e preciso, a ponto de ser capaz de gravar trilhas medindo menos de um centésimo de milímetro de largura. Quando estão sendo gravados dados no disco, a cabeça utiliza seu campo magnético para organizar as moléculas de óxido de ferro da superfície de gravação, fazendo com que os pólos positivos das moléculas fiquem alinhados com o pólo negativo da cabeça e, conseqüentemente, com que os pólos negativos das moléculas fiquem alinhados com o pólo positivo da cabeça. Usamos, neste caso, a velha lei "os opostos se atraem". Como a cabeça de leitura e gravação do HD é um eletroímã, sua polaridade pode ser alternada constantemente. Com o disco girando continuamente, variando a polaridade da cabeça de gravação, variamos também a direção dos pólos positivos e negativos das moléculas da superfície magnética. De acordo com a direção dos pólos, temos um bit 1 ou 0 (sistema binário).

Para gravar as sequências de bits 1 e 0 que formam os dados, a polaridade da cabeça magnética é mudada alguns milhões de vezes por segundo, sempre seguindo ciclos bem determinados. Cada bit é formado no disco por uma seqüência de várias moléculas. Quanto maior for a densidade do disco, menos moléculas serão usadas para armazenar cada bit, e teremos um sinal magnético mais fraco. Precisamos, então, de uma cabeça magnética mais precisa. Quando é preciso ler os dados gravados, a cabeça de leitura capta o campo magnético gerado pelas moléculas alinhadas. A variação entre os sinais magnéticos positivos e negativos gera uma pequena corrente elétrica que caminha através dos fios da bobina. Quando o sinal chega à placa lógica do HD, ele é interpretado como uma seqüência de bits 1 e 0. Desse jeito, o processo de armazenamento de dados em discos magnéticos parece ser simples, e realmente era nos primeiros discos rígidos (como o 305 RAMAC da IBM), que eram construídos de maneira praticamente artesanal. Apesar de nos discos modernos terem sido incorporados vários aperfeiçoamentos, o processo básico continua sendo o mesmo.

Exemplos de sistema de arquivos

Os sistemas de arquivos mais conhecidos são os utilizados pelo Microsoft Windows: NTFS e FAT32 (e FAT ou FAT16). O FAT32, às vezes referenciado apenas como FAT (erradamente, FAT é usado para FAT16), é uma evolução do ainda mais antigo FAT16 introduzida a partir do MS-DOS 4.0. No Windows 95 ORS/2 foi introduzido o FAT32 (uma versão “debugada” do Windows 95, com algumas melhorias, vendida pela Microsoft apenas em conjunto com computadores novos). A partir do Windows NT, foi introduzido um novo sistema de arquivos, o NTFS, que é mais avançado do que o FAT (em nível de segurança, sacrificando algum desempenho), sendo o recurso de permissões de arquivo (sistemas multi-usuário), a mais notável diferença, inexistente nos sistemas FAT e essencial no ambiente empresarial (e ainda a inclusão do metadata), além dos recursos de criptografia e compactação de arquivos.

Em resumo, versões antigas, mono-usuário, como Windows 95, 98 e ME, trabalham com FAT32 (mais antigamente, FAT16). Já versões novas, multi-usuário, como Windows XP e Windows 2000, trabalham primordialmente com o NTFS, embora o sistema FAT seja suportado e você possa criar uma partição FAT nessas versões. No mundo Linux, há uma grande variedade de sistemas de arquivos, sendo alguns dos mais comuns o Ext2, Ext3 e o ReiserFS. O FAT e o NTFS também são suportados tanto para leitura quanto para escrita. No Mundo BSD, o sistema de arquivos é denominado FFS (Fast File System), derivado do antigo UFS (Unix File System). Em 2009, encontramos um novo tipo de sistema de arquivo chamado NFS (Network File System), o qual possibilita que HDs Virtuais sejam utilizadas remotamente, ou seja, um servidor disponibiliza espaço através de suas HDs físicas para que outras pessoas utilizem-nas remotamente como se ela estivesse disponível localmente. Um grande exemplo desse sistema encontramos no Google ou no 4shared, com espaços disponíveis de até 5 GB.

Setor de boot

Quando o computador é ligado, o POST (Power-on Self Test), um pequeno programa gravado em um chip de memória ROM na placa-mãe, que tem a função de “dar a partida”, tentará inicializar o sistema operacional. Independentemente de qual sistema de arquivos se esteja usando, o primeiro setor do disco rígido será reservado para armazenar informações sobre a localização do sistema operacional, que permitem ao BIOS "achá-lo" e iniciar seu carregamento.

No setor de boot é registrado onde o sistema operacional está instalado, com qual sistema de arquivos o disco foi formatado e quais arquivos devem ser lidos para inicializar o computador. Um setor é a menor divisão física do disco, e possui na grande maioria das vezes 512 Bytes (nos CD-ROMs e derivados é de 2048 Bytes). Um cluster, também chamado de agrupamento, é a menor parte reconhecida pelo sistema operacional, e pode ser formado por vários setores. Um arquivo com um número de bytes maior que o tamanho do cluster, ao ser gravado no disco, é distribuído em vários clusters. Porém, um cluster não pode pertencer a mais de um arquivo. Um único setor de 512 Bytes pode parecer pouco, mas é suficiente para armazenar o registro de boot devido ao seu pequeno tamanho. O setor de boot também é conhecido como "trilha MBR", "trilha 0' etc. Como dito, no disco rígido existe um setor chamado Trilha 0, e nele está gravado o (MBR) (Master Boot Record), que significa "Registro de Inicialização Mestre", um estilo de formatação, onde são encontradas informações sobre como está dividido o disco (no sentido lógico)e sobre a ID de cada tabela de partição do disco, que dará o boot. O MBR é lido pelo BIOS, que interpreta a informação e em seguida ocorre o chamado "bootstrap", "levantar-se pelo cadarço", lê as informações de como funciona o sistema de arquivos e efetua o carregamento do sistema operacional. O MBR e a ID da tabela de partição ocupam apenas um setor de uma trilha, o restante dos setores desta trilha não são ocupados, permanecendo vazios, servindo como área de proteção do MBR. É nesta mesma área que alguns vírus (Vírus de Boot) se alojam.

Disquetes, Zip-disks e CD-ROMs não possuem MBR; no entanto, possuem tabela de partição, no caso do CD-ROMs e seu descendentes (DVD-ROM, HDDVD-ROM, BD-ROM...) possuem tabela própria, podendo ser CDFS (Compact Disc File System) ou UDF (Universal Disc Format) ou, para maior compatibilidade, os dois; já os cartões de memória Flash e Pen-Drives possuem tabela de partição e podem ter até mesmo MBR, dependendo de como formatados. O MBR situa-se no primeiro setor da primeira trilha do primeiro prato do HD (setor um, trilha zero, face zero, prato zero). O MBR é constituído pelo bootstrap e pela tabela de partição. O bootstrap é o responsável por analisar a tabela de partição em busca da partição ativa. Em seguida, ele carrega na memória o Setor de Boot da partição. Esta é a função do bootstrap.

A tabela de partição contém informações sobre as partições existentes no disco. São informações como o tamanho da partição, em qual trilha/setor/cilindro ela começa e termina, qual o sistema de arquivos da partição, se é a partição ativa; ao todo, são dez campos. Quatro campos para cada partição possível (por isso, só se pode ter 4 partições primárias, e é por isso também que foi-se criada a partição estendida...), e dez campos para identificar cada partição existente. Quando acaba o POST, a instrução INT 19 do BIOS lê o MBR e o carrega na memória, e é executado o bootstrap. O bootstrap vasculha a tabela de partição em busca da partição ativa, e em seguida carrega na memória o Setor de Boot dela. A função do Setor de Boot é a de carregar na memória os arquivos de inicialização do sistema operacional. O Setor de Boot fica situado no primeiro setor da partição ativa.

Capacidade do disco rígido

A capacidade de um disco rígido atualmente disponível no mercado para uso doméstico/comercial varia de 10 a 2000 GB, assim como aqueles disponíveis para empresas, de até 2 TB. O HD evoluiu muito. O mais antigo possuía 5 MB (aproximadamente 4 disquetes de 3 1/2 HD), sendo aumentada para 30 MB, em seguida para 500 MB (20 anos atrás), e 10 anos mais tarde, HDs de 1 a 3 GB. Em seguida lançou-se um HD de 10 GB e posteriormente um de 15 GB. Posteriormente, foi lançado no mercado um de 20 GB, até os atuais HDs de 60GB a 1TB. As empresas usam maiores ainda: variam de 40 GB até 2 TB, mas a Seagate informou que em 2010 irá lançar um HD de 200 TB (sendo 50 TB por polegada quadrada, contra 70 GB dos atuais HDs) {Fonte:http://www.inovadorsite. cjb. net}.

No entanto, as indústrias consideram 1 GB = 1000 * 1000 * 1000 bytes, pois no Sistema Internacional de Unidades(SI), que trabalha com potências de dez, o prefixo giga quer dizer * 10003 ou * 109 (bilhões), enquanto os sistemas operacionais consideram 1 GB = 1024 * 1024 * 1024 bytes, já que os computadores trabalham com potências de dois e 1024 é a potência de dois mais próxima de mil. Isto causa uma certa disparidade entre o tamanho informado na compra do HD e o tamanho considerado pelo Sistema Operacional, conforme mostrado na tabela abaixo. Além disso, outro fator que pode deixar a capacidade do disco menor do que o anunciado é a formatação de baixo nível (formatação física) com que o disco sai de fábrica.

Informado na Compra Considerado pelo Sistema

10 GB 9,31 GB

15 GB 13,97 GB

20 GB 18,63 GB

30 GB 27,94 GB

40 GB 37,25 GB

80 GB 74,53 GB

120 GB 111,76 GB

160 GB 149,01 GB

200 GB 186,26 GB

250 GB 232,83 GB

300 GB 279,40 GB

500 GB 465,66 GB

750 GB 698,49 GB

1 TB 931,32 GB

1.5 TB 1.396,98 GB

2 TB 1.862,64 GB

2.5 TB (2010)[3] 2.328,30 GB

Todos os valores acimas são aproximações

Toda a vez que um HD é formatado, uma pequena quantidade de espaço é marcada como utilizada.

História do disco rígido

Um antigo disco rígido IBM.O primeiro disco rígido foi construído pela IBM em 1956, e foi lançado em 16 de Setembro de 1957. Era formado por 50 discos magnéticos contendo 50 000 setores, sendo que cada um suportava 100 caracteres alfanuméricos, totalizando uma capacidade de 5 megabytes, incrível para a época. Este primeiro disco rígido foi chamado de 305 RAMAC (Random Access Method of Accounting and Control) e tinha dimensões de 152,4 centímetros de comprimento, 172,72 centimetros de largura e 73,66 centímetros de altura. Em 1973 a IBM lançou o modelo 3340 Winchester, com dois pratos de 30 megabytes e tempo de acesso de 30 milissegundos. Assim criou-se o termo 30/30 Winchester (uma referência à espingarda Winchester 30/30), termo muito usado antigamente para designar HDs de qualquer espécie. Ainda no início da década de 1980, os discos rígidos eram muito caros e modelos de 10 megabytes custavam quase 2 mildólares americanos, enquanto em 2009 compramos modelos de 1.5 terabyte por pouco mais de 100 dólares. Ainda no começo dos anos 80, a mesma IBM fez uso de uma versão pack de discos de 80 megabytes, usado nos sistemas IBM Virtual Machine. Os discos rigidos foram criados originalmente para serem usados em computadores em geral. Mas no século 21 as aplicações para esse tipo de disco foram expandidas e agora são usados em câmeras filmadoras, ou camcorders nos Estados Unidos; tocadores de música como Ipod, mp3 player; PDAs; videogames, e até em celulares. Para exemplos em videogames temos o Xbox360 e o Playstation 3, lançados em 2005 e 2006 respectivamente, com esse diferencial, embora a Microsoft já tivesse lançado seu primeiro Xbox (em 2001) com disco rígido convencional embutido. Já para celular os primeiros a terem esse tecnologia foram os da Nokia e da Samsung. E também devemos lembrar que atualmente o disco rigido não é só interno, existem também os externos, que possibilitam o transporte de grandes quantidades de dados entre computadores sem a necessidade de rede.

Como os dados são gravados e lidos

Os discos magnéticos de um disco rígido são recobertos por uma camada magnética extremamente fina. Na verdade, quanto mais fina for a camada de gravação, maior será sua sensibilidade, e conseqüentemente maior será a densidade de gravação permitida por ela. Poderemos, então, armazenar mais dados num disco do mesmo tamanho, criando HDs de maior capacidade. Os primeiros discos rígidos, assim como os discos usados no início da década de 80, utilizavam a mesma tecnologia de mídia magnética utilizada em disquetes, chamada coated media, que além de permitir uma baixa densidade de gravação, não é muito durável. Os discos atuais já utilizam mídia laminada (plated media), uma mídia mais densa, de qualidade muito superior, que permite a enorme capacidade de armazenamento dos discos modernos. A cabeça de leitura e gravação de um disco rígido funciona como um eletroímã semelhante aos que estudamos nas aulas de ciências e física do colegial, sendo composta de uma bobina de fios que envolve um núcleo de ferro. A diferença é que, num disco rígido, este eletroímã é extremamente pequeno e preciso, a ponto de ser capaz de gravar trilhas medindo menos de um centésimo de milímetro de largura. Quando estão sendo gravados dados no disco, a cabeça utiliza seu campo magnético para organizar as moléculas de óxido de ferro da superfície de gravação, fazendo com que os pólos positivos das moléculas fiquem alinhados com o pólo negativo da cabeça e, conseqüentemente, com que os pólos negativos das moléculas fiquem alinhados com o pólo positivo da cabeça. Usamos, neste caso, a velha lei "os opostos se atraem". Como a cabeça de leitura e gravação do HD é um eletroímã, sua polaridade pode ser alternada constantemente. Com o disco girando continuamente, variando a polaridade da cabeça de gravação, variamos também a direção dos pólos positivos e negativos das moléculas da superfície magnética. De acordo com a direção dos pólos, temos um bit 1 ou 0 (sistema binário).

Para gravar as sequências de bits 1 e 0 que formam os dados, a polaridade da cabeça magnética é mudada alguns milhões de vezes por segundo, sempre seguindo ciclos bem determinados. Cada bit é formado no disco por uma seqüência de várias moléculas. Quanto maior for a densidade do disco, menos moléculas serão usadas para armazenar cada bit, e teremos um sinal magnético mais fraco. Precisamos, então, de uma cabeça magnética mais precisa. Quando é preciso ler os dados gravados, a cabeça de leitura capta o campo magnético gerado pelas moléculas alinhadas. A variação entre os sinais magnéticos positivos e negativos gera uma pequena corrente elétrica que caminha através dos fios da bobina. Quando o sinal chega à placa lógica do HD, ele é interpretado como uma seqüência de bits 1 e 0. Desse jeito, o processo de armazenamento de dados em discos magnéticos parece ser simples, e realmente era nos primeiros discos rígidos (como o 305 RAMAC da IBM), que eram construídos de maneira praticamente artesanal. Apesar de nos discos modernos terem sido incorporados vários aperfeiçoamentos, o processo básico continua sendo o mesmo.

Exemplos de sistema de arquivos

Os sistemas de arquivos mais conhecidos são os utilizados pelo Microsoft Windows: NTFS e FAT32 (e FAT ou FAT16). O FAT32, às vezes referenciado apenas como FAT (erradamente, FAT é usado para FAT16), é uma evolução do ainda mais antigo FAT16 introduzida a partir do MS-DOS 4.0. No Windows 95 ORS/2 foi introduzido o FAT32 (uma versão “debugada” do Windows 95, com algumas melhorias, vendida pela Microsoft apenas em conjunto com computadores novos). A partir do Windows NT, foi introduzido um novo sistema de arquivos, o NTFS, que é mais avançado do que o FAT (em nível de segurança, sacrificando algum desempenho), sendo o recurso de permissões de arquivo (sistemas multi-usuário), a mais notável diferença, inexistente nos sistemas FAT e essencial no ambiente empresarial (e ainda a inclusão do metadata), além dos recursos de criptografia e compactação de arquivos.

Em resumo, versões antigas, mono-usuário, como Windows 95, 98 e ME, trabalham com FAT32 (mais antigamente, FAT16). Já versões novas, multi-usuário, como Windows XP e Windows 2000, trabalham primordialmente com o NTFS, embora o sistema FAT seja suportado e você possa criar uma partição FAT nessas versões. No mundo Linux, há uma grande variedade de sistemas de arquivos, sendo alguns dos mais comuns o Ext2, Ext3 e o ReiserFS. O FAT e o NTFS também são suportados tanto para leitura quanto para escrita. No Mundo BSD, o sistema de arquivos é denominado FFS (Fast File System), derivado do antigo UFS (Unix File System). Em 2009, encontramos um novo tipo de sistema de arquivo chamado NFS (Network File System), o qual possibilita que HDs Virtuais sejam utilizadas remotamente, ou seja, um servidor disponibiliza espaço através de suas HDs físicas para que outras pessoas utilizem-nas remotamente como se ela estivesse disponível localmente. Um grande exemplo desse sistema encontramos no Google ou no 4shared, com espaços disponíveis de até 5 GB.

Setor de boot

Quando o computador é ligado, o POST (Power-on Self Test), um pequeno programa gravado em um chip de memória ROM na placa-mãe, que tem a função de “dar a partida”, tentará inicializar o sistema operacional. Independentemente de qual sistema de arquivos se esteja usando, o primeiro setor do disco rígido será reservado para armazenar informações sobre a localização do sistema operacional, que permitem ao BIOS "achá-lo" e iniciar seu carregamento.

No setor de boot é registrado onde o sistema operacional está instalado, com qual sistema de arquivos o disco foi formatado e quais arquivos devem ser lidos para inicializar o computador. Um setor é a menor divisão física do disco, e possui na grande maioria das vezes 512 Bytes (nos CD-ROMs e derivados é de 2048 Bytes). Um cluster, também chamado de agrupamento, é a menor parte reconhecida pelo sistema operacional, e pode ser formado por vários setores. Um arquivo com um número de bytes maior que o tamanho do cluster, ao ser gravado no disco, é distribuído em vários clusters. Porém, um cluster não pode pertencer a mais de um arquivo. Um único setor de 512 Bytes pode parecer pouco, mas é suficiente para armazenar o registro de boot devido ao seu pequeno tamanho. O setor de boot também é conhecido como "trilha MBR", "trilha 0' etc. Como dito, no disco rígido existe um setor chamado Trilha 0, e nele está gravado o (MBR) (Master Boot Record), que significa "Registro de Inicialização Mestre", um estilo de formatação, onde são encontradas informações sobre como está dividido o disco (no sentido lógico)e sobre a ID de cada tabela de partição do disco, que dará o boot. O MBR é lido pelo BIOS, que interpreta a informação e em seguida ocorre o chamado "bootstrap", "levantar-se pelo cadarço", lê as informações de como funciona o sistema de arquivos e efetua o carregamento do sistema operacional. O MBR e a ID da tabela de partição ocupam apenas um setor de uma trilha, o restante dos setores desta trilha não são ocupados, permanecendo vazios, servindo como área de proteção do MBR. É nesta mesma área que alguns vírus (Vírus de Boot) se alojam.

Disquetes, Zip-disks e CD-ROMs não possuem MBR; no entanto, possuem tabela de partição, no caso do CD-ROMs e seu descendentes (DVD-ROM, HDDVD-ROM, BD-ROM...) possuem tabela própria, podendo ser CDFS (Compact Disc File System) ou UDF (Universal Disc Format) ou, para maior compatibilidade, os dois; já os cartões de memória Flash e Pen-Drives possuem tabela de partição e podem ter até mesmo MBR, dependendo de como formatados. O MBR situa-se no primeiro setor da primeira trilha do primeiro prato do HD (setor um, trilha zero, face zero, prato zero). O MBR é constituído pelo bootstrap e pela tabela de partição. O bootstrap é o responsável por analisar a tabela de partição em busca da partição ativa. Em seguida, ele carrega na memória o Setor de Boot da partição. Esta é a função do bootstrap.

A tabela de partição contém informações sobre as partições existentes no disco. São informações como o tamanho da partição, em qual trilha/setor/cilindro ela começa e termina, qual o sistema de arquivos da partição, se é a partição ativa; ao todo, são dez campos. Quatro campos para cada partição possível (por isso, só se pode ter 4 partições primárias, e é por isso também que foi-se criada a partição estendida...), e dez campos para identificar cada partição existente. Quando acaba o POST, a instrução INT 19 do BIOS lê o MBR e o carrega na memória, e é executado o bootstrap. O bootstrap vasculha a tabela de partição em busca da partição ativa, e em seguida carrega na memória o Setor de Boot dela. A função do Setor de Boot é a de carregar na memória os arquivos de inicialização do sistema operacional. O Setor de Boot fica situado no primeiro setor da partição ativa.

Capacidade do disco rígido

A capacidade de um disco rígido atualmente disponível no mercado para uso doméstico/comercial varia de 10 a 2000 GB, assim como aqueles disponíveis para empresas, de até 2 TB. O HD evoluiu muito. O mais antigo possuía 5 MB (aproximadamente 4 disquetes de 3 1/2 HD), sendo aumentada para 30 MB, em seguida para 500 MB (20 anos atrás), e 10 anos mais tarde, HDs de 1 a 3 GB. Em seguida lançou-se um HD de 10 GB e posteriormente um de 15 GB. Posteriormente, foi lançado no mercado um de 20 GB, até os atuais HDs de 60GB a 1TB. As empresas usam maiores ainda: variam de 40 GB até 2 TB, mas a Seagate informou que em 2010 irá lançar um HD de 200 TB (sendo 50 TB por polegada quadrada, contra 70 GB dos atuais HDs) {Fonte:http://www.inovadorsite. cjb. net}.

No entanto, as indústrias consideram 1 GB = 1000 * 1000 * 1000 bytes, pois no Sistema Internacional de Unidades(SI), que trabalha com potências de dez, o prefixo giga quer dizer * 10003 ou * 109 (bilhões), enquanto os sistemas operacionais consideram 1 GB = 1024 * 1024 * 1024 bytes, já que os computadores trabalham com potências de dois e 1024 é a potência de dois mais próxima de mil. Isto causa uma certa disparidade entre o tamanho informado na compra do HD e o tamanho considerado pelo Sistema Operacional, conforme mostrado na tabela abaixo. Além disso, outro fator que pode deixar a capacidade do disco menor do que o anunciado é a formatação de baixo nível (formatação física) com que o disco sai de fábrica.

Informado na Compra Considerado pelo Sistema

10 GB 9,31 GB

15 GB 13,97 GB

20 GB 18,63 GB

30 GB 27,94 GB

40 GB 37,25 GB

80 GB 74,53 GB

120 GB 111,76 GB

160 GB 149,01 GB

200 GB 186,26 GB

250 GB 232,83 GB

300 GB 279,40 GB

500 GB 465,66 GB

750 GB 698,49 GB

1 TB 931,32 GB

1.5 TB 1.396,98 GB

2 TB 1.862,64 GB

2.5 TB (2010)[3] 2.328,30 GB

Todos os valores acimas são aproximações

Toda a vez que um HD é formatado, uma pequena quantidade de espaço é marcada como utilizada.

quarta-feira, 28 de abril de 2010

Memória RAM

Diferentes tipos de RAM. A partir do alto: DIP, SIPP, SIMM 30 pin, SIMM 72 pin, DIMM (168-pin), DDR DIMM (184-pin)Memória de acesso aleatório (do inglês Random Access Memory, frequentemente abreviado para RAM) é um tipo de memória que permite a leitura e a escrita, utilizada como memória primária em sistemas eletrônicos digitais.

O termo acesso aleatório identifica a capacidade de acesso a qualquer posição em qualquer momento, por oposição ao acesso sequencial, imposto por alguns dispositivos de armazenamento, como fitas magnéticas.

O nome não é verdadeiramente apropriado, já que outros tipos de memória (como a ROM) também permitem o acesso aleatório a seu conteúdo. O nome mais apropriado seria Memória de Leitura e Escrita.

Apesar do conceito de memória de acesso aleatório ser bastante amplo, atualmente o termo é usado apenas para definir um dispositivo eletrônico que o implementa, basicamente um tipo específico de chip. Nesse caso, também fica implícito que é uma memória volátil, isto é, todo o seu conteúdo é perdido quando a alimentação da memória é desligada.

Algumas memórias RAM necessitam que os seus dados sejam frequentemente refrescados (atualizados), podendo então ser designadas por DRAM (Dynamic RAM) ou RAM Dinâmica. Por oposição, aquelas que não necessitam de refrescamento são normalmente designadas por SRAM (Static RAM) ou RAM Estática.

Do ponto de vista da sua forma física, uma RAM pode ser constituída por um circuito integrado DIP ou por um módulo SIMM, DIMM, SO-DIMM, etc. Para computadores pessoais elas são normalmente adquiridas em módulos de memória (popularmente conhecido como pente, pelo fato de que seus contatos se parecem com os dentes de um pente de cabelo), que são placas de circuito impresso que já contém várias memórias já montadas e configuradas de acordo com a arquitetura usada na máquina.

A capacidade de uma memória é medida em Bytes, kilobytes (1 KB = 1024 ou 210 Bytes), megabytes (1 MB = 1024 KB ou 220 Bytes) ou gigabytes (1 GB = 1024 MB ou 230 Bytes).

A velocidade de funcionamento de uma memória é medida em Hz ou MHz. Este valor está relacionado com a quantidade de blocos de dados que podem ser transferidos durante um segundo. Existem no entanto algumas memórias RAM que podem efetuar duas transferências de dados no mesmo ciclo de clock, duplicando a taxa de transferência de informação para a mesma frequência de trabalho. Além disso, a colocação das memórias em paralelo (propriedade da arquitetura de certos sistemas) permite multiplicar a velocidade aparente da memória.

A memória principal de um computador baseado na Arquitetura de Von-Neumann é constituída por RAM. É nesta memória que são carregados os programas em execução e os respectivos dados do utilizador. Uma vez que se trata de memória volátil, os seus dados são perdidos quando o computador é desligado. Para evitar perdas de dados, é necessário salvar a informação para suporte não volátil (por ex. disco rígido), ou memória secundária.

Há também quem diga que uma memória volátil pode ser "burlada" ou "congelada" com hidrogênio liquido, ou seja, mesmo a memória sendo desligada, ela não perderia seus dados.

Invenção

O Escritório de Patentes americano forneceu a patente 3,387,286, "Field Effect Transistor Memory", de 4 de julho de 1968, para Robert Langdon, da IBM, por uma célula DRAM de um transistor (1 bit).

DRAM

SRAM

SIMM

DIMM

SO-DIMM

SDR SDRAM

DDR SDRAM

DDR2

DDR3

Memória ROM

Memória cache

Memória flash

GDDR

Memória bolha

RAM-CMOS

terça-feira, 27 de abril de 2010

Microprocessador

O microprocessador, popularmente chamado de processador, é um circuito integrado que realiza as funções de cálculo e tomada de decisão de um computador. Todos os computadores e equipamentos eletrônicos baseiam-se nele para executar suas funções.

Arquitetura interna de um microprocessador dedicado para processamento de imagens de ressonância magnética, a fotografia foi aumentada 600 vezes, sob luz ultravioleta para se enxergar os detalhes

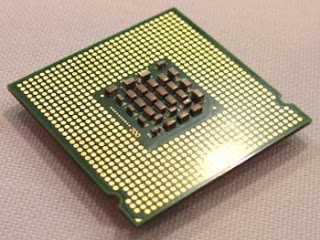

Vista inferior de um Athlon XP 1800+ núcleo Palomino, um microprocessador moderno.O microprocessador moderno é um circuito integrado formado por uma camada chamada de mesa epitaxial de silício, trabalhada de modo a formar um cristal de extrema pureza, laminada até uma espessura mínima com grande precisão, depois cuidadosamente mascarada por um processo fotográfico e dopada pela exposição a altas temperaturas em fornos que contêm misturas gasosas de impurezas. Este processo é repetido tantas vezes quanto necessário à formação da microarquitetura do componente.

Responsável pela execução das instruções num sistema, o microprocessador, escolhido entre os disponíveis no mercado, determina, em certa medida a capacidade de processamento do computador e também o conjunto primário de instruções que ele compreende. O sistema operativo é construído sobre este conjunto.

O próprio microprocessador subdivide-se em várias unidades, trabalhando em altas freqüências. A ULA(Unidade Lógica Aritmética), unidade responsável pelos cálculos aritméticos e lógicos e os registradores são parte integrante do microprocessador na família x86, por exemplo.

Embora seja a essência do computador, o microprocessador diferente do microcontrolador, está longe de ser um computador completo. Para que possa interagir com o utilizador precisa de: memória, dispositivos de entrada/saída, um clock, controladores e conversores de sinais, entre outros. Cada um desses circuitos de apoio interage de modo peculiar com os programas e, dessa forma, ajuda a moldar o funcionamento do computador.

História

Intel 8008, um dos primeiros microprocessadores comerciais.O primeiro microprocessador comercial foi inventado pela Intel em 1971 para atender uma empresa japonesa que precisava de um circuito integrado especial.[1] A Intel projectou o 4004 que era um circuito integrado programável que trabalhava com registradores de 4 bits, 46 instruções, clock de 740Khz e possuía cerca de 2300 transistores. Percebendo a utilidade desse invento a Intel prosseguiu com o desenvolvimento de novos microprocessadores: 8008 (o primeiro de 8 bits) e a seguir o 8080 e o microprocessador 8085. O 8080 foi um grande sucesso e tornou-se a base para os primeiros microcomputadores pessoais na década de 1970 graças ao sistema operacional CP/M. Da Intel saíram alguns funcionários que fundaram a Zilog, que viria a lançar o microprocessador Z80, com instruções compatíveis com o 8080 (embora muito mais poderoso que este) e também de grande sucesso. A Motorola possuía o 68000 e a MOS Technology o 6502. Todos esses microprocessadores de 8 bits foram usados em muitos computadores pessoais (Bob Sinclair, Apple, TRS, Commodore, etc). Em 1981 a IBM decidiu lançar-se no mercado de computadores pessoais e no seu IBM-PC utilizou um dos primeiros microprocessadores de 16 bits, o 8088 (derivado do seu irmão 8086 lançado em 1978) que viria a ser o avô dos computadores atuais. A Apple nos seus computadores Macintosh utilizava os processadores da Motorola, a família 68000 (de 32 bits). Outros fabricantes também tinham os seus microprocessadores de 16 bits, a Zilog tinha o Z8000, a Texas Instruments o TMS9900, a National Semiconductor tinha o 16032,mas nenhum fabricante teve tanto sucesso como a Intel, que sucessivamente foi lançando melhoramentos na sua linha 80X86, tendo surgido assim (por ordem cronológica) o 8086, 8088, 80186, 80188, 80286, 80386, 80486, Pentium, Pentium Pro, Pentium MMX, Pentium II, Pentium III, Pentium IV, Pentium M, Pentium D e Pentium Dual Core. Para o IBM-AT foi utilizado o 80286, depois um grande salto com o 80386 que podia trabalhar com memória virtual e multitarefa, o 80486 com coprocessador matemático embutido e finalmente a linha Pentium, com pipeline de processamento. Como grande concorrente da Intel, a AMD aparece inicialmente como fabricante de microprocessadores da linha x86 alternativa mas a partir de um certo momento deixou de correr atrás da Intel e partiu para o desenvolvimento de sua própria linha de microprocessadores: K6, Athlon, Duron, Turion, Sempron, etc. Paralelamente à disputa entre Intel e AMD, a IBM possuia a linha PowerPC utilizada principalmente pelos microcomputadores da Apple.

A evolução tecnológica envolvida é surpreendentemente grande, de microprocessadores que trabalhavam com clock de dezenas de kHz e que podiam processar alguns milhares de instruções por segundo, atingiu-se clocks na casa dos 4 GHz e poder de processamento de dezenas de bilhões de instruções por segundo. A complexidade também cresceu: de alguns milhares de transístores para centenas de milhões de transístores numa mesma pastilha.

O CPU tem como função principal unificar todo o sistema, controlar as funções realizadas por cada unidade funcional, e é também responsável pela execução de todos os programas do sistema, que deverão estar armazenados na memória principal.

Componentes

O processador é composto por alguns componentes, cada um tendo uma função específica no processamento dos programas.

Unidade lógica e aritmética

A Unidade lógica e aritmética (ULA) é a responsável por executar efetivamente as instruções dos programas, como instruções lógicas, matemáticas, desvio, etc.

Unidade de controle

A Unidade de controle (UC) é responsável pela tarefa de controle das ações a serem realizadas pelo computador, comandando todos os outros componentes.

Registradores

Os registradores são pequenas memórias velozes que armazenam comandos ou valores que são utilizados no controle e processamento de cada instrução. Os registradores mais importantes são:

Contador de Programa (PC) – Sinaliza para a próxima instrução a ser executada;

Registrador de Instrução (IR) – Registra a execução da instrução;

Memory management unit

Ver artigo principal: Memory management unit

A MMU (em inglês: Memory Management Unit) é um dispositivo de hardware que transforma endereços virtuais em endereços físicos e administra a memória principal do computador.

Unidade de ponto flutuante

Nos processadores atuais são implementadas unidades de cálculo de números reais. Tais unidades são mais complexas que ULAs e trabalham com operandos maiores, com tamanhos típicos variando entre 64 e 128 bits.

Frequência de operação

O relógio do sistema (Clock) é um circuito oscilador a cristal (efeito piezoelétrico) que tem a função de sincronizar e ditar a medida de tempo de transferência de dados no computador. Esta freqüência é medida em ciclos por segundo, ou Hertz. A capacidade de processamento do processador não está relacionada exclusivamente à frequência do relógio, mas também a outros fatores como: largura dos barramentos, quantidade de memória cache, arquitetura do processador, tecnologia de co-processamento, tecnologia de previsão de saltos (branch prediction), tecnologia de pipeline, conjunto de instruções, etc.

O aumento da frequência de operação nominal do processador é denominado overclocking.

Arquitetura

Existem duas principais arquiteturas usadas em processadores:

A arquitetura de Von Newmann. Esta arquitetura caracteriza-se por apresentar um barramento externo compartilhado entre dados e endereços. Embora apresente baixo custo, esta arquitetura apresenta desempenho limitado pelo gargalo do barramento.

A arquitetura de Harvard. Nesta arquitetura existem dois barramentos externos independentes (e normalmente também memórias independentes) para dados e endereços. Isto reduz de forma sensível o gargalo de barramento, que é uma das principais barreiras de desempenho, em detrimento do encarecimento do sistema como um todo.

Modelos de computação

Existem dois modelos de computação usados em processadores:

CISC (em inglês: Complex Instruction Set Computing, Computador com um Conjunto Complexo de Instruções), usada em processadores Intel e AMD; possui um grande conjunto de instruções (tipicamente centenas) que são armazenadas em uma pequena memória não-volátil interna ao processador. Cada posição desta memória contém as microinstruções, ou seja, os passos a serem realizados para a execução de cada instrução. Quanto mais complexa a instrução, mais microinstruções ela possuirá e mais tempo levará para ser executada. Ao conjunto de todas as microinstruções contidas no processador denominamos microcódigo. Esta técnica de computação baseada em microcódigo é denominada microprogramação.

RISC (em inglês: Reduced Instruction Set Computing, Computador com um Conjunto Reduzido de Instruções) usada em processadores PowerPC (da Apple, Motorola e IBM) e SPARC (SUN); possui um conjunto pequeno de instruções (tipicamente algumas dezenas) implementadas diretamente em hardware. Nesta técnica não é necessário realizar a leitura em uma memória e, por isso, a execução das instruções é muito rápida (normalmente um ciclo de clock por instrução). Por outro lado, as instruções são muito simples e para a realização de certas tarefas são necessárias mais instruções que no modelo CISC.

Exemplos de microprocessadores

Uma GPU.Microprocessadores — São utilizados nos computadores pessoais, onde são chamadas de Unidade Central de Processamento (CPU), workstations e mainframes. Podem ser programados para executar as mais variadas tarefas.

Processadores Digitais de Sinal (DSP do inglês Digital Signal Processor) — são microprocessadores especializados em processamento digital de sinal usados para processar sinais de áudio, vídeo, etc., quer em tempo real quer em off-line. Estão presentes, por exemplo, em aparelhos de CD, DVD e televisores digitais. Em geral, realizam sempre uma mesma tarefas simples.

Microcontroladores — Processadores relativamente flexíveis, de relativo baixo custo, que podem ser utilizados em projetos de pequeno tamanho. Podem trazer facilidades como conversores A/D embutidos, ou um conjunto de instruções próprias para comunicação digital através de algum protocolo específico.

GPU — (ou Unidade de Processamento Gráfico), é um microprocessador especializado em processar gráficos. São utilizadas em placas de vídeo para fazer computação gráfica.

Propósito geral e dedicado

Durante o processo de desenvolvimento do design de um processador, uma das características que se leva em conta é o uso que ele se destina. Processadores gráficos e controladoras por exemplo não tem o mesmo fim que um processador central. Processadores de propósito geral podem executar qualquer tipo de software, embora sua execução seja mais lenta que o mesmo sendo executado em um processador especializado. Processadores dedicados são fabricados para executarem tarefas específicas, como criptografia, processamento vetorial e gráfico, sendo nesse caso bem mais rápidos do que processadores de propósito geral em tarefas equivalentes. No caso do processamento gráfico, existem as GPUs, que são microprocessadores geralmente com memória dedicada e especialmente desenvolvidos para cálculos gráficos. Nem sempre os processadores seguem definidamente esses dois modelos, sendo o motivo disso que muitos processadores modernos incorporam processadores especializados (co-processador), para cálculos de criptografia, processamento de vetores, etc.

Processadores multinucleares

Até os dias de hoje usou-se microprocessadores para atividades domésticas ou de negócios com simples núcleo. Atualmente estão sendo utilizados microprocessadores de múltiplos núcleos para melhorar a capacidade de processamento. Espera-se que no futuro os Sistemas Operacionais domésticos sejam compilados para trabalhar com processadores de múltiplos núcleos corretamente, realizando assim inúmeras tarefas ao mesmo tempo (como já acontece com os supercomputadores).

Sistemas multiprocessados

Em muitos sistemas o uso de um só processador é insuficiente. A solução nesses casos é usar dois ou mais processadores em multi processamento, aumentando assim a quantidade de processadores disponíveis ao sistema operacional. Sistemas multiprocessados podem ser de basicamente dois tipos:

Multiprocessamento simétrico (SMP): os processadores compartilham a mesma memória, embora possam ter caches separadas. O sistema operacional deve estar preparado para trabalhar com coerência de caches e, principalmente, evitar condições de corrida na memória principal.

Acesso não uniforme à memória (NUMA): a cada processador é associado um banco de memória. Nesse caso, o sistema operacional trata cada banco separadamente, pois cada banco tem um custo de acesso diferente, dependendo de qual o processador a que está associado e onde está sendo executado o processo que tenta acessar a memória.

Capacidade de processamento

A capacidade de processamento de um microprocessador é de certa forma difícil de medir, uma vez que esse desempenho pode se referir a quantidade máxima teória de instruções que podem ser executadas por segundo, que tipos de instruções são essas, tendo também a influência de sua arquitetura e de sua comunicação externa, mas num contexto geral a capacidade máxima teórica de processamento é medida em Flops (instruções de ponto flutuante), podendo essa ser de precisão simples, dupla, quádrupla, dependendo do contexto, e em MIPS (milhões de instruções por segundo), sendo essas operações com números inteiros. Somente a capacidade máxima teórica de um microprocessador não define seu desempenho, somente dá uma noção da sua capacidade, uma vez que sua arquitetura, barramento com a memória entre outros também influenciam no seu desempenho final, sendo assim, sua capacidade de processamento é medida comparando a velocidade de execução de aplicativos reais, podendo assim, testar seu desempenho em atividades comuns.

Arquitetura interna de um microprocessador dedicado para processamento de imagens de ressonância magnética, a fotografia foi aumentada 600 vezes, sob luz ultravioleta para se enxergar os detalhes

Vista inferior de um Athlon XP 1800+ núcleo Palomino, um microprocessador moderno.O microprocessador moderno é um circuito integrado formado por uma camada chamada de mesa epitaxial de silício, trabalhada de modo a formar um cristal de extrema pureza, laminada até uma espessura mínima com grande precisão, depois cuidadosamente mascarada por um processo fotográfico e dopada pela exposição a altas temperaturas em fornos que contêm misturas gasosas de impurezas. Este processo é repetido tantas vezes quanto necessário à formação da microarquitetura do componente.

Responsável pela execução das instruções num sistema, o microprocessador, escolhido entre os disponíveis no mercado, determina, em certa medida a capacidade de processamento do computador e também o conjunto primário de instruções que ele compreende. O sistema operativo é construído sobre este conjunto.

O próprio microprocessador subdivide-se em várias unidades, trabalhando em altas freqüências. A ULA(Unidade Lógica Aritmética), unidade responsável pelos cálculos aritméticos e lógicos e os registradores são parte integrante do microprocessador na família x86, por exemplo.

Embora seja a essência do computador, o microprocessador diferente do microcontrolador, está longe de ser um computador completo. Para que possa interagir com o utilizador precisa de: memória, dispositivos de entrada/saída, um clock, controladores e conversores de sinais, entre outros. Cada um desses circuitos de apoio interage de modo peculiar com os programas e, dessa forma, ajuda a moldar o funcionamento do computador.

História

Intel 8008, um dos primeiros microprocessadores comerciais.O primeiro microprocessador comercial foi inventado pela Intel em 1971 para atender uma empresa japonesa que precisava de um circuito integrado especial.[1] A Intel projectou o 4004 que era um circuito integrado programável que trabalhava com registradores de 4 bits, 46 instruções, clock de 740Khz e possuía cerca de 2300 transistores. Percebendo a utilidade desse invento a Intel prosseguiu com o desenvolvimento de novos microprocessadores: 8008 (o primeiro de 8 bits) e a seguir o 8080 e o microprocessador 8085. O 8080 foi um grande sucesso e tornou-se a base para os primeiros microcomputadores pessoais na década de 1970 graças ao sistema operacional CP/M. Da Intel saíram alguns funcionários que fundaram a Zilog, que viria a lançar o microprocessador Z80, com instruções compatíveis com o 8080 (embora muito mais poderoso que este) e também de grande sucesso. A Motorola possuía o 68000 e a MOS Technology o 6502. Todos esses microprocessadores de 8 bits foram usados em muitos computadores pessoais (Bob Sinclair, Apple, TRS, Commodore, etc). Em 1981 a IBM decidiu lançar-se no mercado de computadores pessoais e no seu IBM-PC utilizou um dos primeiros microprocessadores de 16 bits, o 8088 (derivado do seu irmão 8086 lançado em 1978) que viria a ser o avô dos computadores atuais. A Apple nos seus computadores Macintosh utilizava os processadores da Motorola, a família 68000 (de 32 bits). Outros fabricantes também tinham os seus microprocessadores de 16 bits, a Zilog tinha o Z8000, a Texas Instruments o TMS9900, a National Semiconductor tinha o 16032,mas nenhum fabricante teve tanto sucesso como a Intel, que sucessivamente foi lançando melhoramentos na sua linha 80X86, tendo surgido assim (por ordem cronológica) o 8086, 8088, 80186, 80188, 80286, 80386, 80486, Pentium, Pentium Pro, Pentium MMX, Pentium II, Pentium III, Pentium IV, Pentium M, Pentium D e Pentium Dual Core. Para o IBM-AT foi utilizado o 80286, depois um grande salto com o 80386 que podia trabalhar com memória virtual e multitarefa, o 80486 com coprocessador matemático embutido e finalmente a linha Pentium, com pipeline de processamento. Como grande concorrente da Intel, a AMD aparece inicialmente como fabricante de microprocessadores da linha x86 alternativa mas a partir de um certo momento deixou de correr atrás da Intel e partiu para o desenvolvimento de sua própria linha de microprocessadores: K6, Athlon, Duron, Turion, Sempron, etc. Paralelamente à disputa entre Intel e AMD, a IBM possuia a linha PowerPC utilizada principalmente pelos microcomputadores da Apple.

A evolução tecnológica envolvida é surpreendentemente grande, de microprocessadores que trabalhavam com clock de dezenas de kHz e que podiam processar alguns milhares de instruções por segundo, atingiu-se clocks na casa dos 4 GHz e poder de processamento de dezenas de bilhões de instruções por segundo. A complexidade também cresceu: de alguns milhares de transístores para centenas de milhões de transístores numa mesma pastilha.

O CPU tem como função principal unificar todo o sistema, controlar as funções realizadas por cada unidade funcional, e é também responsável pela execução de todos os programas do sistema, que deverão estar armazenados na memória principal.

Componentes

O processador é composto por alguns componentes, cada um tendo uma função específica no processamento dos programas.

Unidade lógica e aritmética

A Unidade lógica e aritmética (ULA) é a responsável por executar efetivamente as instruções dos programas, como instruções lógicas, matemáticas, desvio, etc.

Unidade de controle

A Unidade de controle (UC) é responsável pela tarefa de controle das ações a serem realizadas pelo computador, comandando todos os outros componentes.

Registradores

Os registradores são pequenas memórias velozes que armazenam comandos ou valores que são utilizados no controle e processamento de cada instrução. Os registradores mais importantes são:

Contador de Programa (PC) – Sinaliza para a próxima instrução a ser executada;

Registrador de Instrução (IR) – Registra a execução da instrução;

Memory management unit

Ver artigo principal: Memory management unit

A MMU (em inglês: Memory Management Unit) é um dispositivo de hardware que transforma endereços virtuais em endereços físicos e administra a memória principal do computador.

Unidade de ponto flutuante

Nos processadores atuais são implementadas unidades de cálculo de números reais. Tais unidades são mais complexas que ULAs e trabalham com operandos maiores, com tamanhos típicos variando entre 64 e 128 bits.

Frequência de operação

O relógio do sistema (Clock) é um circuito oscilador a cristal (efeito piezoelétrico) que tem a função de sincronizar e ditar a medida de tempo de transferência de dados no computador. Esta freqüência é medida em ciclos por segundo, ou Hertz. A capacidade de processamento do processador não está relacionada exclusivamente à frequência do relógio, mas também a outros fatores como: largura dos barramentos, quantidade de memória cache, arquitetura do processador, tecnologia de co-processamento, tecnologia de previsão de saltos (branch prediction), tecnologia de pipeline, conjunto de instruções, etc.

O aumento da frequência de operação nominal do processador é denominado overclocking.

Arquitetura

Existem duas principais arquiteturas usadas em processadores:

A arquitetura de Von Newmann. Esta arquitetura caracteriza-se por apresentar um barramento externo compartilhado entre dados e endereços. Embora apresente baixo custo, esta arquitetura apresenta desempenho limitado pelo gargalo do barramento.

A arquitetura de Harvard. Nesta arquitetura existem dois barramentos externos independentes (e normalmente também memórias independentes) para dados e endereços. Isto reduz de forma sensível o gargalo de barramento, que é uma das principais barreiras de desempenho, em detrimento do encarecimento do sistema como um todo.

Modelos de computação

Existem dois modelos de computação usados em processadores:

CISC (em inglês: Complex Instruction Set Computing, Computador com um Conjunto Complexo de Instruções), usada em processadores Intel e AMD; possui um grande conjunto de instruções (tipicamente centenas) que são armazenadas em uma pequena memória não-volátil interna ao processador. Cada posição desta memória contém as microinstruções, ou seja, os passos a serem realizados para a execução de cada instrução. Quanto mais complexa a instrução, mais microinstruções ela possuirá e mais tempo levará para ser executada. Ao conjunto de todas as microinstruções contidas no processador denominamos microcódigo. Esta técnica de computação baseada em microcódigo é denominada microprogramação.

RISC (em inglês: Reduced Instruction Set Computing, Computador com um Conjunto Reduzido de Instruções) usada em processadores PowerPC (da Apple, Motorola e IBM) e SPARC (SUN); possui um conjunto pequeno de instruções (tipicamente algumas dezenas) implementadas diretamente em hardware. Nesta técnica não é necessário realizar a leitura em uma memória e, por isso, a execução das instruções é muito rápida (normalmente um ciclo de clock por instrução). Por outro lado, as instruções são muito simples e para a realização de certas tarefas são necessárias mais instruções que no modelo CISC.

Exemplos de microprocessadores

Uma GPU.Microprocessadores — São utilizados nos computadores pessoais, onde são chamadas de Unidade Central de Processamento (CPU), workstations e mainframes. Podem ser programados para executar as mais variadas tarefas.

Processadores Digitais de Sinal (DSP do inglês Digital Signal Processor) — são microprocessadores especializados em processamento digital de sinal usados para processar sinais de áudio, vídeo, etc., quer em tempo real quer em off-line. Estão presentes, por exemplo, em aparelhos de CD, DVD e televisores digitais. Em geral, realizam sempre uma mesma tarefas simples.

Microcontroladores — Processadores relativamente flexíveis, de relativo baixo custo, que podem ser utilizados em projetos de pequeno tamanho. Podem trazer facilidades como conversores A/D embutidos, ou um conjunto de instruções próprias para comunicação digital através de algum protocolo específico.

GPU — (ou Unidade de Processamento Gráfico), é um microprocessador especializado em processar gráficos. São utilizadas em placas de vídeo para fazer computação gráfica.

Propósito geral e dedicado

Durante o processo de desenvolvimento do design de um processador, uma das características que se leva em conta é o uso que ele se destina. Processadores gráficos e controladoras por exemplo não tem o mesmo fim que um processador central. Processadores de propósito geral podem executar qualquer tipo de software, embora sua execução seja mais lenta que o mesmo sendo executado em um processador especializado. Processadores dedicados são fabricados para executarem tarefas específicas, como criptografia, processamento vetorial e gráfico, sendo nesse caso bem mais rápidos do que processadores de propósito geral em tarefas equivalentes. No caso do processamento gráfico, existem as GPUs, que são microprocessadores geralmente com memória dedicada e especialmente desenvolvidos para cálculos gráficos. Nem sempre os processadores seguem definidamente esses dois modelos, sendo o motivo disso que muitos processadores modernos incorporam processadores especializados (co-processador), para cálculos de criptografia, processamento de vetores, etc.

Processadores multinucleares

Até os dias de hoje usou-se microprocessadores para atividades domésticas ou de negócios com simples núcleo. Atualmente estão sendo utilizados microprocessadores de múltiplos núcleos para melhorar a capacidade de processamento. Espera-se que no futuro os Sistemas Operacionais domésticos sejam compilados para trabalhar com processadores de múltiplos núcleos corretamente, realizando assim inúmeras tarefas ao mesmo tempo (como já acontece com os supercomputadores).

Sistemas multiprocessados

Em muitos sistemas o uso de um só processador é insuficiente. A solução nesses casos é usar dois ou mais processadores em multi processamento, aumentando assim a quantidade de processadores disponíveis ao sistema operacional. Sistemas multiprocessados podem ser de basicamente dois tipos:

Multiprocessamento simétrico (SMP): os processadores compartilham a mesma memória, embora possam ter caches separadas. O sistema operacional deve estar preparado para trabalhar com coerência de caches e, principalmente, evitar condições de corrida na memória principal.

Acesso não uniforme à memória (NUMA): a cada processador é associado um banco de memória. Nesse caso, o sistema operacional trata cada banco separadamente, pois cada banco tem um custo de acesso diferente, dependendo de qual o processador a que está associado e onde está sendo executado o processo que tenta acessar a memória.

Capacidade de processamento

A capacidade de processamento de um microprocessador é de certa forma difícil de medir, uma vez que esse desempenho pode se referir a quantidade máxima teória de instruções que podem ser executadas por segundo, que tipos de instruções são essas, tendo também a influência de sua arquitetura e de sua comunicação externa, mas num contexto geral a capacidade máxima teórica de processamento é medida em Flops (instruções de ponto flutuante), podendo essa ser de precisão simples, dupla, quádrupla, dependendo do contexto, e em MIPS (milhões de instruções por segundo), sendo essas operações com números inteiros. Somente a capacidade máxima teórica de um microprocessador não define seu desempenho, somente dá uma noção da sua capacidade, uma vez que sua arquitetura, barramento com a memória entre outros também influenciam no seu desempenho final, sendo assim, sua capacidade de processamento é medida comparando a velocidade de execução de aplicativos reais, podendo assim, testar seu desempenho em atividades comuns.

domingo, 25 de abril de 2010

Twitter (pronuncia-se "tuíter") é uma rede social e servidor para microblogging que permite aos usuários que enviem e recebam atualizações pessoais de outros contatos (em textos de até 140 caracteres, conhecidos como "tweets"), através do website do serviço, por SMS e por softwares específicos de gerenciamento.

As atualizações são exibidas no perfil de um usuário em tempo real e também enviadas a outros usuários seguidores que tenham assinado para recebê-las. As atualizações de um perfil ocorrem através por meio de site do Twitter, por RSS, por SMS ou programa especializado para gerenciamento. O serviço é gratuito pela internet, entretanto, usando o recurso de SMS pode ocorrer a cobrança pela operadora telefônica.

Desde sua criação em 2006 por Jack Dorsey, o Twitter ganhou extensa notabilidade e popularidade por todo mundo. Algumas vezes é descrito como o "SMS da Internet".[1]

Estimativas de usuários

A estimativa do número de usuários é baseada em pesquisas independentes já que a empresa não informa oficialmente número de contas ativas. Em novembro de 2008, Jeremiah Owyang estimou que o Twitter possuia entre 4 a 5 milhões de usuários.[2] Já em maio de 2009, outro estudo analisou mais de 11 milhões e meio de contas de usuários.[3]

Em Fevereiro de 2009 o blog "Compete.com" elegeu o Twitter em terceiro lugar como rede social mais usada (Facebook em primeiro lugar, seguido do MySpace).[4]

[editar] Serviços semelhantes

Devido ao sucesso do Twitter, um grande número de serviços semelhantes foram lançados. Alguns são disponibilizados em países específicos, outros unem outras funções, como a partilha de arquivos que era oferecido pelo Pownce.

Um estudo da Universidade de Harvard concluiu que apenas 10% dos usuários produzem 90% do conteúdo.[5]

Em janeiro de 2010 foi realizada a primeira conexão e acesso pessoal à Internet de origem espacial, utilizando o Twitter.[6] O astronauta Timothy Creamer, escreveu "Hello Twitterverse" no serviço de microblogging,[6] através do endereço do Twitter http://twitter.com/astro_tj.[7]

Segundo o grupo de pesquisa norte-americano Web Ecology, a língua portuguesa é a segunda mais utilizada pelo Twitter.[8] Enquanto o estudo da Semiocast mostra que a Língua portuguesa é a terceira mais utilizada, atrás do Inglês e do Japonês. [9] [10]

Índice [esconder]

1 Estimativas de usuários

2 Serviços semelhantes

3 Retweet

4 Usos e manifestações sociais

5 Publicidade

6 Perfil do usuário brasileiro

7 Twitter List

8 Trending Topics

9 Controvérsias

9.1 Críticas ao Twitter

9.2 Invasão de Hackers

9.3 Casos de suicídios

10 Ver também

11 Referências

12 Ligações externas

Retweet

O retweet é uma função do Twitter que consiste em replicar uma determinada mensagem de um usuário para a lista de seguidores, dando crédito a seu autor original.[11][12] Na página de início do site existe um botão chamado retwittear, que faz o envio automático da mensagem para todos seguidores da pessoa. Antigamente, os usuários realizavam isto de forma manual, acrescentando um RT ao lado do @nick de quem escreveu.

Usos e manifestações sociais

Em Março de 2009, o Twitter foi uma das principais ferramentas de divulgação do Pillow Fight Day - uma guerra pública de travesseiros acontecida em várias cidades do mundo. São Paulo, Brasília, Santos, Fortaleza, Araraquara, Belém, Belo Horizonte, Bragança Paulista, Campo Grande, Curitiba, Florianópolis, Goiânia, Guarulhos, Manaus, Natal, Porto Alegre, Rio de Janeiro, Recife, Ribeirão Preto, Salvador, Santa Maria, São João Del Rei, São Luís, Sorocaba, Uberlândia e Vitória foram algumas cidades brasileiras em que houve a manifestação.

Se destacou na mídia o uso do Twitter durante as manifestações políticas ocorridas na Moldávia em reação ao resultado das eleições legislativas no ínicio de 2009. A ferramenta também esteve presente no debate político e na movimentação da oposição durante as eleições presidenciais no Irã em 2009. Durante o Apagão elétrico de 2009, as primeiras informações das regiões atingidas pelo blecaute foi fornecida através dos usuários do Twitter, através de postagens via celular, e lida por emissoras de rádio que faziam plantão naquele momento.

Publicidade

O Twitter também tem sido constantemente utilizado por grandes empresas para a divulgação de suas marcas, através de constantes atualizações, sempre ligando o "consumidor" a uma página onde possa encontrar mais informações sobre o serviço ou produto oferecido. Além disso, o Twitter tem se mostrado um ótimo instrumento para o fortalecimento das marcas no ambiente virtual, pois agrega seguidores que recebem as atualizações enviadas pelas empresas, porém ainda é uma ferramenta que deve ser melhor explorada para esse fim.

No artigo publicado em 14 de abril de 2009, no The New York Times, a jornalista Claire Cain Miller afirmou que a utilidade mais produtiva do Twitter tem sido para aquelas empresas que desejam ouvir os clientes e oferecer reações imediatas às opiniões deles. A Dell, por exemplo, percebeu que os clientes estavam reclamando de que o apóstrofo e as teclas de retorno estavam próximas demais no laptop Dell Mini 9. O problema foi reparado. Na Starbucks, os clientes costumavam reclamar deixando notas em uma caixa de sugestões. Agora, eles podem também enviar a reclamações ou sugestões via Twitter.

No Brasil, o destaque da mídia para ações publicitárias no Twitter tem sido para a venda de um apartamento realizada pela construtora Tecnisa. O perfil da empresa no Twitter foi criado em 20 de Fevereiro de 2008, mas, somente em 13 de Julho de 2008, começou a ser utilizado para uma divulgação. Tratava-se do lançamento do Acquaplay, em Santos.

Em 23 de Fevereiro de 2009, Romeo Bussarello, diretor de marketing da empresa chegou a afirmar: "usamos para comunicar lançamentos e novidades (…) Tenho consciência de que não vou vender um apartamento via Twitter." Porém, cerca de 4 meses depois, a construtora concluiu a primeira venda por meio do Twitter. A promoção realizada na rede social oferecia R$2.000,00 em vale-compras, além de armários e cozinhas planejados, somente para as compras geradas por meio desta forma de contacto. A oferta levou o consumidor a efetivar a compra de uma unidade de três suítes no empreendimento Verana, localizado no Alto da Lapa, em São Paulo, ao custo de R$ 500 mil. "Provavelmente este é o produto mais caro vendido pelo Twitter no mundo. E, com certeza, é a primeira venda concretizada por uma empresa do segmento da construção civil, utilizando redes sociais. Esta conquista inédita fortalece nossa estratégia de divulgação on-line dos imóveis. Afinal, conseguimos um excelente resultado com um baixo investimento", afirmou Busarello.

O Google e a Microsoft entraram em um acordo com o Twitter para que os tweets postados diariamente pelos milhões de usuários da rede social, apareçam nos resultados dos buscadores, tanto do Google, quanto da Microsoft, no caso o Bing. O Google está pagando US$ 15 milhões e a Microsoft US$ 10 milhões e serão os primeiros a fazer experiências com os dados coletados.[13] O Yahoo também pode vir a fazer parte desse acordo.[14]

Perfil do usuário brasileiro

De acordo com uma pesquisa realizada pela agência Bullet, a maioria (61%) dos usuários do Twitter no Brasil é composta por homens na faixa de 21 a 30 anos, solteiros, localizados nos estados São Paulo e Rio de Janeiro. Na maior parte, são pessoas com ensino superior completo e renda mensal compreendida entre R$ 1001 e R$ 5000.

Ainda segundo a pesquisa, esse público gasta cerca de 50h semanais conectados à Internet. Cerca de 60% dele é considerado formadores de opinião: possuem um blog; conhecem a ferramenta através de amigos ou posts em outros blogs.

Sobre o uso da ferramenta por empresas, a pesquisa informa um cenário muito favorável. A maioria (51%) dos usuários consultados disseram achar interessantes os perfis corporativos, desde que sejam utilizados com relevância. Aproximadamente 50% dos usuários nunca participaram de ações promocionais. Ainda assim, consideram uma experiência interessante. Cerca de 30% já participaram de alguma ação publicitária e 70% seguem ou já seguiram algum perfil corporativo.

Na pesquisa, foram consultados 3268 brasileiros por meio do site da Bullet e o Migre.me, no período de 27 a 29 de abril de 2009.

Twitter List

Twitter List é um recurso disponível no Twitter que permite ao usuário criar listas compartilháveis de usuários. O que dinamiza a leitura dos tweets já que se torna possível ler o conteúdo postado por grupos de seguidores.

Trending Topics

Os Trending Topics ou TTs são uma lista em tempo real dos nomes mais postados no Twitter pelo mundo todo. Valem para essa lista as tagtemas (#) e nomes próprios. A lista não é aberta, isso significa que o usuário deve estar logado para ter acesso.

A iniciativa é semelhante ao Google Trends, mas por ter o nome diferenciado, a terminologia acabou sendo associada diretamente ao Twitter.

Os Trending Topics ganharam tanta força que são comentados frequentemente pelos usuários como TT e mobilizam correntes para colocar um tema na lista e ter exposição mundial.

Desde o dia 26 de janeiro o usuário tem a opção de escolher a região que os Trending Topics irão mostrar. As áreas são atualmente restritas a esses países:

Worldwide (mundo inteiro)

Brasil

Canadá

Irlanda

México

Reino Unido

Estados Unidos

Também está disponível a possibilidade de restringir por cidades. Atualmente disponíveis as seguintes cidades:

Atlanta

Baltimore

Boston

Chicago

Dallas-Ft. Worth

Houston

Londres

Los Angeles

Nova Iorque

Filadélfia

San Antonio

San Francisco

Seattle

São Paulo

Washington, D.C.

O recurso de Trending Topics usa por padrão a abrangência total (worldwide). Como os TTs são calculados a partir de todos os tweets do mundo, estão mais relacionados aos EUA e Inglaterra que são as maiores comunidades. Em alguns países onde o Twitter ainda não disponibizou serviços estatísticos existem websites não oficiais. No Brasil, por exemplo, o website Blablabra [15] permite a visualização de vários dados.

Controvérsias

Críticas ao Twitter

Algumas empresas mundiais estão proibindo o uso do Twitter, pois a limitação de 140 caracteres é supostamente prejudicial para um jornalismo e qualidade.[16] Alem disso, o escritor, roteirista, jornalista, dramaturgo e vencedor de um prêmio Nobel de Literatura, José Saramago fez uma dura crítica ao Twitter dizendo: "Os tais 140 caracteres reflectem algo que já conhecíamos: a tendência para o monossílabo como forma de comunicação. De degrau em degrau, vamos descendo até o grunhido. Entretanto, o propósito do Twitter não é literário, mas informativo."[17]

Invasão de Hackers

Em agosto de 2009, o Twitter foi alvo do primeiro ataque dos hackers. Quem tentava acessar ou logar no site, encontrou o site pichado pelos hackers, que ficou por duas horas até sair do ar.

Na madrugada do dia 18 de dezembro de 2009, o Twitter foi invadido por Hackers. Ao clicar no Twitter, usuário era redirecionado para página com aviso de grupo chamado "Exército Cibernético do Irã". O site saiu do ar por cerca de uma hora, informa o portal da rede de TV norte-americana CNN. Em seu blog oficial, o Twitter disse que "os registros DNS (sigla em inglês para Sistema de Nomes de Domínios, que é um mecanismo que traduz o nome dos sites nos números que identificam as páginas) ficaram temporariamente comprometidos, mas agora foram consertados". A rede social não deu mais detalhes sobre o assunto.[18]

Coincidência ou não o caso do Irã com twitter é antigo. O Governo do Irã foi envolvido do caso, pois em junho de 2009, através do twitter, ocorreram manifestantes contra a a reeleição de Mahmud Ahmadnejad, por conta das graves denúnicas de fraude eleitoral, provocando, inúmeras reações negativas internas e externas. O twitter foi bloqueado diversas vezes no país.

Em 25 de março de 2010, a Polícia anunciou a prisão no centro da França, o "Hacker-croll", um pirata virtual que roubou as senhas de vários famosos no Twitter, entre eles, o grupo musical britânico Duran Duran, o "presidente de uma grande empresa pública francesa" e o atual presidente dos Estados Unidos, Barack Obama. O jovem de 25 anos foi detido após uma investigação conjunta entre autoridades da França e dos Estados Unidos, diz o jornal Le Parisien. A prisão do jovem só foi falicitada, após criar blog no qual narrava o sucesso das invasões, não só no Twitter, mas também em outras redes sociais como o Facebook e em contas pessoais de e-mail.[19]

Casos de suicídios

Em agosto de 2009, a publicitária brasileira de descedência japonesa Marisa Toma, mais conhecida como Ematoma, de 33 anos foi encontrada morta dentro do apartamento onde morava na cidade de São Paulo. Segundo investigações, Marisa Toma cometeu suicídio, ao golpear faca no peito no apartamento na cidade de São Paulo. Antes de se matar, deixou recado suicida no twitter que recebe nome ematoma,[20] que já saiu do ar. Não deixou recado os motivos pelo suicídio, mas nas últimas semanas, ela estava deprimida. Era proprietária do site Objetos de Desejo.[21]